02-11

Red Hat lanza servidor de inferencia de IA para cualquier modelo en la Nube híbrida

2025-05-23

IDOPRESS

2025-05-23

IDOPRESS

Impulsado por vLLM y mejorado con Neural Magic,Red Hat AI Inference Server ofrece una interferencia de IA en la Nube híbrida,con mayor rendimiento y a bajo costo.

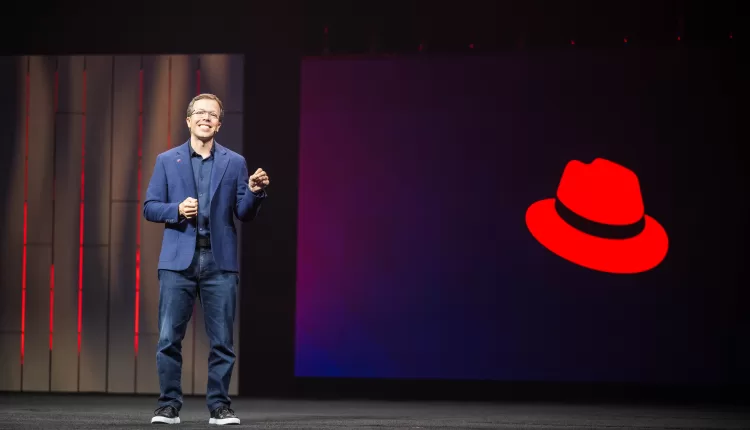

Matt Hicks. Foto: Red Hat

Comparte

En el marco de Red Hat Summit,la compañía estadounidense proveedora de soluciones de código abierto presentó Red Hat AI Inference Server,un servidor de inferencia de Inteligencia Artificial (IA) creado a partir del proyecto comunitario vLLM y optimizado por la integración de las tecnologías de Neural Magic,la empresa cuya adquisición completó este año.

El presidente y CEO de Red Hat,Matt Hicks,expuso que esta tecnología permitirá desplegar la IA Generativa en cualquier modelo,acelerador y Nube. Y enfatizó que el futuro de la IA será abierto.

El director de Tecnología (CTO),Chris Wright,explicó que vLLM habilitará todo el hardware. El también vicepresidente Senior de Ingeniería Global dijo que el código y las licencias abiertas permitirán crear modelos más pequeñosy estos modelos abiertos ya están compitiendo con los grandes modelos cerrados propietarios. Como ejemplo citó R1 de DeepSeek,que introdujo el razonamiento.

Wright rememoró que en 2024 comenzó a hablarse mucho de agentes,pero en 2025 el desafío es gestionarlos de manera confiable y reducir costos. Ahora,dijo,se están enfocando en el escalado del tiempo de inferencia porque es como pasar la IA a producción y este tiene un “prellenado” que brinda el contexto entero.

El CTO dijo que hoy en día se habla de frameworks “agénticos”. También dijo que,con la introducción del Model Context Protocol (MCP) por parte de Anthropic,la IA empezará a llegar más a la realidad.

Simultáneamente,Red Hat presentó el proyecto llm-d a partir de vLLM,el proyecto comunitario nacido en la Universidad de California en Berkeley en 2023. El CTO explicó que llm-d ofrece inferencia a escala,IA Generativa ubicua e innovación abierta en colaboración con socios como CoreWeave,Google,IBM Research y Nvidia,y con el soporte de AMD,Cisco,Hugging Face,Intel,Lambda y Mistral AI.

En el contexto de su magno evento anual,celebrado en Boston,Red Hat anunció una serie de alianzas,incluida una con Meta para integrar Llama Stack y,de esta forma,traer el modelo Llama de código abierto al ambiente empresarial de su plataforma de IA.

En cuanto al futuro agéntico,Wright aseguró que los agentes son el futuro de la IA empresarial y visualiza a Llama Stack y MCP como estándares tempranos para habilitar despliegues de IA agéntica,por lo que,al integrarlos a su plataforma,ofrecerá una plataforma unificada para modelos y agentes.

RHEL 10

Adicionalmente,la empresa lanzó Red Hat Enterprise Linux (RHEL) 10,la última versión de su sistema operativo empresarial de código abierto.

De acuerdo con la empresa,RHEL 10 ofrece una plataforma que aporta agilidad,flexibilidad y facilidad de gestión,al tiempo que proporciona un eje central estratégico para que la TI empresarial pueda hacer frente a la creciente complejidad y mantiene un perfil de seguridad reforzado contra amenazas informáticas futuras.

Declaración: este artículo se reproduce desde otros medios. El propósito de la reimpresión es transmitir más información. No significa que este sitio web esté de acuerdo con sus puntos de vista y sea responsable de su autenticidad, y no tiene ninguna responsabilidad legal. Todos los recursos de este sitio se recopilan en Internet. El propósito de compartir es solo para el aprendizaje y la referencia de todos. Si hay una infracción de derechos de autor o propiedad intelectual, por favor déjenos un mensaje.